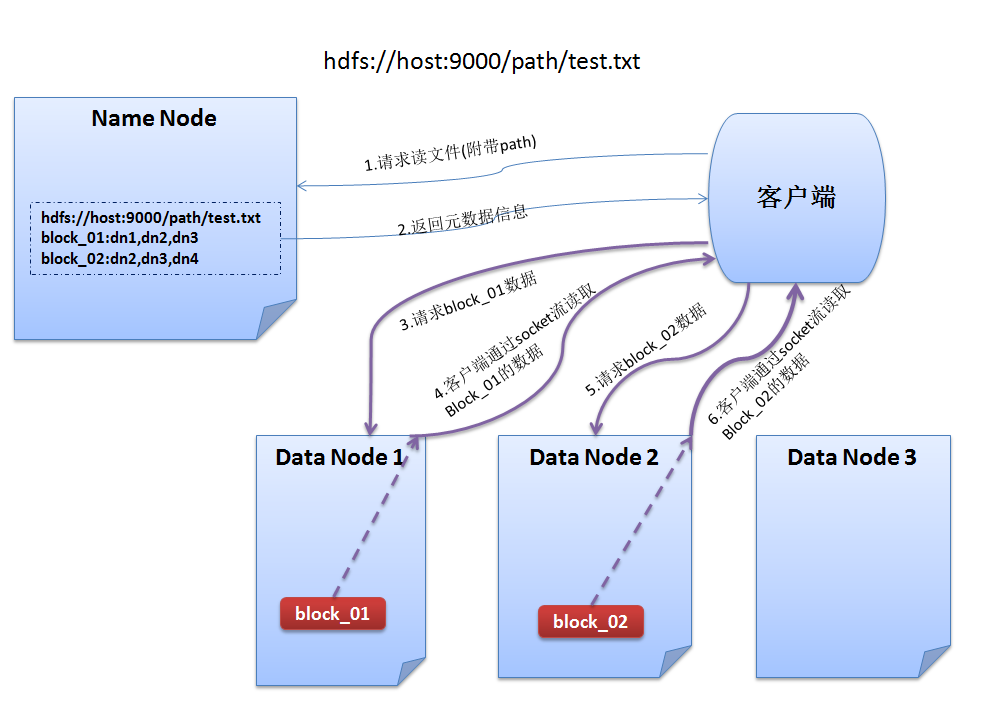

1. HDFS读数据流程

1、与NameNode通信查询元数据,找到文件块所在的DataNode服务器

2、挑选一台DataNode(网络拓扑上的就近原则,如果都一样,则随机挑选一台DataNode)服务器,请求建立socket流

3、DataNode开始发送数据(从磁盘里面读取数据放入流,以packet(一个packet为64kb)为单位来做校验)

4、客户端以packet为单位接收,先在本地缓存,然后写入目标文件

流程如下:

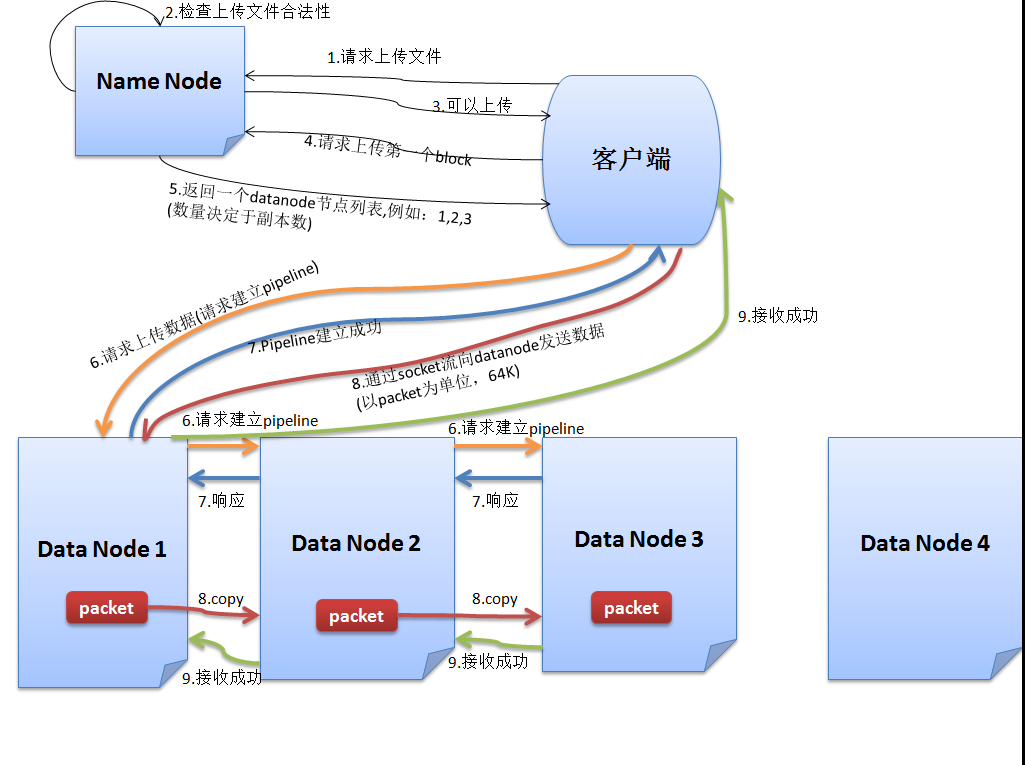

2. HDFS写数据流程

1、跟NameNode通信请求上传文件,NameNode检查目标文件是否已经存在,父目录是否已经存在

2、NameNode返回是否可以上传

3、Client先对文件进行切分,请求第一个block该传输到哪些DataNode服务器上

4、NameNode返回3个DataNode服务器DataNode 1,DataNode 2,DataNode 3

5、Client请求3台中的一台DataNode 1(网络拓扑上的就近原则,如果都一样,则随机挑选一台DataNode)上传数据(本质上是一个RPC调用,建立pipeline),DataNode 1收到请求会继续调用DataNode 2,然后DataNode 2调用DataNode 3,将整个pipeline建立完成,然后逐级返回客户端

6、Client开始往DataNode 1上传第一个block(先从磁盘读取数据放到一个本地内存缓存),以pocket为单位。写入的时候DataNode会进行数据校验,它并不是通过一个packet进行一次校验而是以chunk为单位进行校验(512byte)。DataNode 1收到一个packet就会传给DataNode 2,DataNode 2传给DataNode 3,DataNode 1每传一个pocket会放入一个应答队列等待应答

7、当一个block传输完成之后,Client再次请求NameNode上传第二个block的服务器.

流程如下: